Le fotocamere hanno potenzialità inaspettate e, se integrate con adeguato software, diventano strumenti capaci di competere con sistemi di gran lunga più costosi. Con modifica Full Range di Profilocolore, possono “vedere” dagli ultravioletti agli infrarossi per estendere il potenziale in diversi campi d’applicazione: dall'Arte alla Medicina, dall'Investigazione al monitoraggio dell'Ambiente.

Introduzione

Il termine “fotografia”, composizione di foto- (dal greco ![]() , -

, -![]() , luce) e -grafia (dal greco

, luce) e -grafia (dal greco ![]() , disegno), implica intrinsecamente la registrazione su un supporto qualsiasi di quanto vediamo ad occhio nudo, cioè di quanto vediamo con la “luce” e con i nostri occhi. Possiamo anche dire che la fotografia è il risultato di un gioco a tre dove i partecipanti sono una sorgente di luce, un soggetto ed un sistema di cattura dell'immagine.

, disegno), implica intrinsecamente la registrazione su un supporto qualsiasi di quanto vediamo ad occhio nudo, cioè di quanto vediamo con la “luce” e con i nostri occhi. Possiamo anche dire che la fotografia è il risultato di un gioco a tre dove i partecipanti sono una sorgente di luce, un soggetto ed un sistema di cattura dell'immagine.

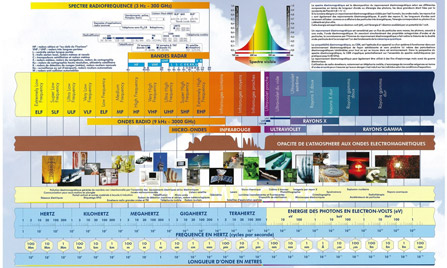

Ma la luce altro non è che un insieme di onde elettromagnetiche le cui lunghezze d'onda cadono in un intervallo ben preciso che noi chiamiamo, appunto, luce visibile. Appena usciamo da questo intervallo di onde elettromagnetiche visibili (comprese tra il blu ed il rosso come nell'arcobaleno) tutti i termini che includono la parola “foto” decadono e si passa a termini che includono la parola “radio”.

Ad esempio un fotometro è uno strumento per misurare l'intensità della luce visibile, mentre un radiometro è uno strumento per misurare l'intensità di una radiazione in un intervallo di lunghezze d'onda qualsiasi. Uno spettrofotometro restituisce l'analisi di una radiazione elettromagnetica fornendo l'energia trasportata per ogni lunghezza d'onda tra quelle appartenenti alla luce visibile, mentre uno spettroradiometro è uno strumento che restituisce un grafico delle energie di una radiazione in una zona qualsiasi dello spettro elettromagnetico (inclusa la zona visibile).

|

|

|

Spettro elettromagnetico completo | Fonte: Laboratorio di misure Emitech

|

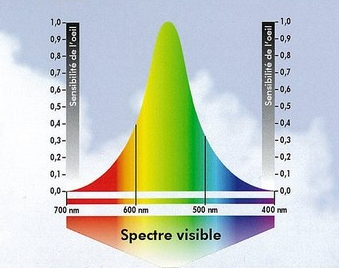

Spettro visibile e sensibilità dell'occhio

|

|

Figura 1 Spettro elettromagnetico e spettro visibile

|

|

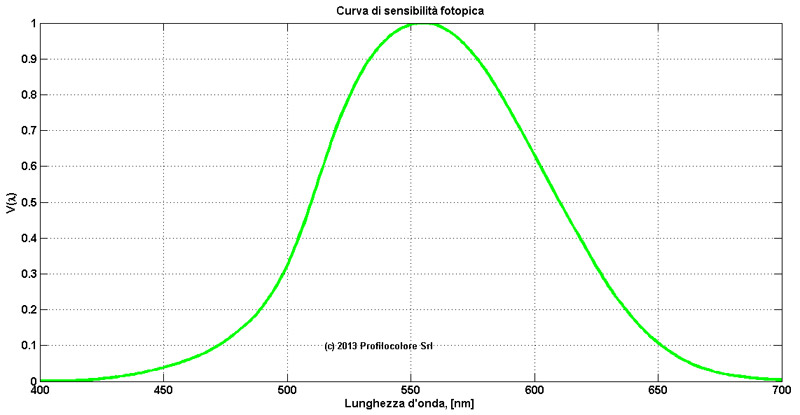

Le misure radiometriche sono dirette, nel senso che vengono misurate grandezze fisiche (energia, potenza, etc.), invece nelle misure fotometriche le stesse grandezze (energia, potenza etc.) vengono prima pesate con la curva di sensibilità dell'occhio, la così detta curva di sensibilità fotopica, che scende a valore nullo per le lunghezze d'onda al di fuori della luce visibile. Le misure fotometriche vengono utilizzare per rappresentare fenomeni legati alla luce così come vengono percepiti dall'occhio, che non ha un comportamento lineare.

|

|

|

Fotografia in trasparenza con luce visibile

Vetrata, Daniela Zambolin |

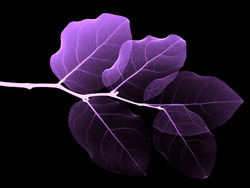

Radiografia di foglie in trasparenza

con raggi X |

|

Figura 3: Trasparenze in luce visibile e raggi X

|

|

Allora possiamo considerare la fotografia come una specializzazione in luce visibile di un campo applicativo molto più vasto, dove i tre partecipanti al gioco sono una sorgente di onde elettromagnetiche di qualsiasi lunghezza d'onda, un soggetto con il quale queste onde abbiano una interazione (alcune materie infatti sono trasparenti, cioè non interagiscono, con certe lunghezze d'onda), ed un sistema che registri il risultato della interazione di questa energia con il soggetto. Pensiamo ad esempio ad una radiografia: questa non è altro che una fotografia eseguita per trasparenza invece che per riflessione, e con onde elettromagnetiche nella banda dei raggi-X invece che della luce visibile. Il principio è esattamente lo stesso con il quale si farebbe ad esempio una fotografia in luce visibile alla vetrata di una chiesa, vista in trasparenza.

Ma a cosa serve avere di uno stesso soggetto immagini provenienti da lunghezze d'onda diverse?

Serve ad avere una maggiore conoscenza della materia di cui è formato quel soggetto. Prendiamo ad esempio un dipinto. La luce visibile riflessa trasporta fino ai nostri occhi, o ad un sistema di ripresa fotografico, una informazione che tecnicamente si chiama immagine di riflettanza spettrale, e che noi comunemente chiamiamo fotografia a colori. Cioè la luce che incide sul dipinto, rimbalzando sulla superficie subisce una modificazione nelle sue componenti spettrali, e quando arriva al nostro occhio ci farà percepire punto per punto il colore e la luminosità del dipinto stesso, ovvero la luce che illumina il dipinto ci permetterà di vederne la superficie.

Se invece “illuminiamo” in trasparenza il dipinto con una sorgente di raggi X, ed utilizziamo un sistema che rilevi una immagine a quelle lunghezze d'onda (una lastra radiografica ad esempio), allora otterremo una così detta radiografia che conterrà come informazione, punto per punto, la densità totale che i raggi X hanno dovuto attraversare prima di emergere dall'altra parte, ovvero, grossolanamente, lo spessore puntuale del dipinto.

La tecnologia ci consente oggi di avere sensori digitali praticamente per qualsiasi lunghezza d'onda. Siamo quindi nella condizione di poter ottenere, qualunque sia la lunghezza d'onda utilizzata, una immagine digitale, cioè una immagine nella quale ad ogni punto (pixel) viene associato un valore numerico proporzionale alla riflettanza o alla trasmittanza del soggetto.

La rappresentazione numerica è una gran cosa e ci permette, rispetto alla precedente rappresentazione analogica, di calibrare il sistema di ripresa e fare in modo che una immagine sia, in ultima analisi, una misura punto per punto della scena ripresa.

Per concludere questa breve introduzione diciamo quindi che se potessimo guardare il mondo attraverso dei super-occhi in grado di “vedere” lunghezze d'onda in una banda molto più grande di quella visibile, vedremmo la realtà intorno a noi con una quantità di informazioni sulla materia molto più ricca.

Vedremo in questo eXperience come una fotocamera modificata Full Range, corredata di opportuno software e filtri ottici, ci permette in realtà di ottenere proprio questo in una gamma di lunghezze d'onda dagli ultravioletti agli infrarossi.

Sensibilità di una fotocamera standard

Ogni casa costruttrice di fotocamere ha come prima obiettivo quello di produrre un sistema in grado di restituire una immagine della scena ripresa, la più fedele possibile, ovvero con colori e luminosità corrispondenti il più possibile a quelli reali.

Per ottenere questo è necessario che una fotocamera si comporti in modo simile possibile all'occhio. In realtà oggi molte fotocamere non solo si comportano in modo simile all'occhio, dal punto di vista colorimetrico, ma spesso mostrano capacità di discernimento dei colori anche superiori come documentato nell’eXperience “Sensibilità allo spettro dei sensori Nikon FX e DX: sulla via del colore”.

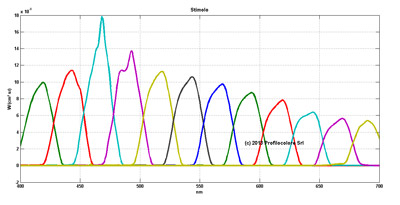

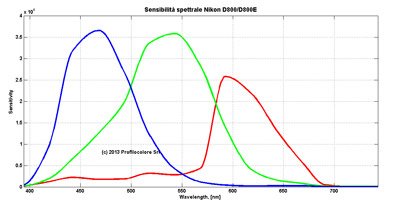

Il modo più completo per conoscere le caratteristiche cromatiche di una fotocamera è quello di sottoporla ad una misura di sensibilità spettrale. Questa consiste nell'illuminare il sensore con una sorgente a banda stretta con lunghezza d'onda centrale variabile nell'arco di tutta la banda visibile. Ad ogni incremento della lunghezza d'onda centrale si misura contemporaneamente l'energia fornita alla fotocamera ed il valor medio dei pixel dei tre canali, rosso, verde e blu, della matrice di Bayer. Il rapporto tra energia fornita e risposta numerica della fotocamera rappresenta la sensibilità della fotocamera in quel canale a quelle lunghezza d'onda. Raccordando tutti i punti con una opportuna funzione di interpolazione si ottengono le curve di sensibilità spettrale dei tre canali, rosso verde e blu.

|

|

|

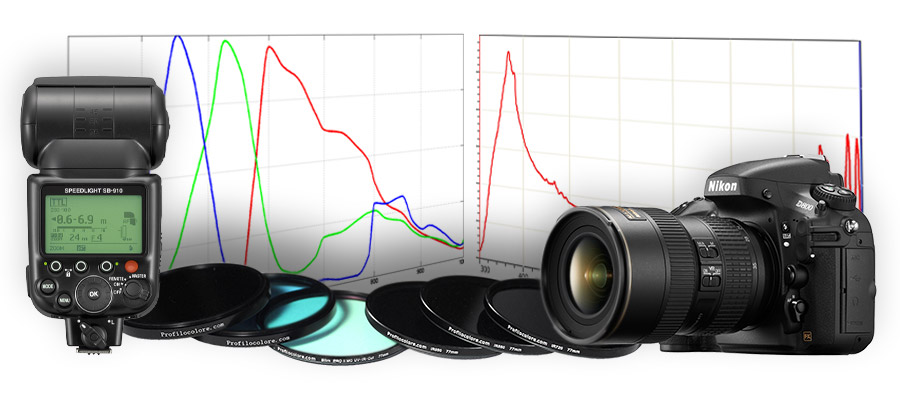

Stimolo luminoso con sorgenti a banda stretta

|

Sensibilità spettrale dei tre canali R, G, B di una D800/D800E

|

I sensori delle fotocamere per fotografia in luce visibile sono costruiti a partire da silicio semiconduttore con tecnologia simile a quella utilizzata per la fabbricazione dei circuiti integrati e dei microprocessori. Tutti i sensori al silicio presentano una sensibilità spettrale nativa che va da circa 300 a circa 1.200 nanometri. I costruttori di fotocamere, per limitare il funzionamento di questi sensori alla banda visibile pongono davanti al sensore uno o più filtri che nel loro complesso riducono a zero la sensibilità a tutte quelle lunghezze d'onda non desiderate.

|

|

.jpg) |

|

Sensibilità spettrale nativa dei sensori al silicio

|

Trasmittanza spettrale di un tipico filtro UV-IRcut che limita la sensibilità della fotocamera alla banda visibile

|

Modifica di una fotocamera Full Range

Abbiamo visto dunque quale è la sensibilità spettrale di un sensore al silicio, quale è la trasmittanza spettrale del filtro che ne limita la sensibilità alla sola banda visibile ed infine la sensibilità spettrale dei tre canali RGB di una fotocamera standard. Vedremo ora cosa va fatto per modificare una fotocamera e quale è l'effetto della matrice di Bayer, cioè della specializzazione dei pixel del sensore nei colori rosso, verde e blu, al di fuori dello spettro visibile.

È sufficiente rimuovere il filtro UV-IR cut per ripristinare la piena sensibilità del sensore al silicio? Cosa succede alla sensibilità spettrale? Cosa succede all'intero sistema ottico? Potremo usare gli stessi obiettivi di prima? Funzionerà ancora l'autofocus? Come cambia la qualità dell'immagine? E cosa succede al rumore del sensore? Come faremo a calcolare l'esposizione? Quali “colori” vedremo, ad esempio, in live view e che senso avranno? Cosa dovremo utilizzare per illuminare la scena da fotografare in una banda così larga? Potremo continuare a riprendere anche fotografie “normali”? Quali filtri dovremo utilizzare? Daremo una risposta a tutte queste domande nei prossimi paragrafi.

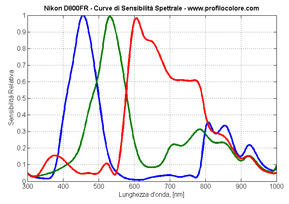

SENSIBILITÀ SPETTRALE FULL RANGE

La risposta la troviamo solo eseguendo nuovamente una misura della sensibilità spettrale della fotocamera, ma questa volta dopo aver rimosso il filtro UV-IR cut. I grafici che ne risultano, per i canali rosso verde e blu, sono piuttosto interessanti perché hanno un andamento imprevisto, ed imprevedibile. La fotocamera che abbiamo analizzato è la D800FR, cioè una Nikon D800 modificata in Full Range.

|

|

|

|

Nikon D800

|

Sensibilità spettrale di una D800/D800E

|

Sensibilità spettrale di una D800/D800E modificata in Full Range (D800FR)

|

Innanzi tutto, rimanendo nella zona del visibile si vede come il canale rosso presenta una sensibilità superiore a quella mostrata nella fotocamera standard. Questo si giustifica con la grande sensibilità del silicio proprio in questa banda, e rende anche ragione della forma (e colore) del filtro UV-IR cut che presenta una attenuazione maggiore nel rosso rispetto al verde ed al blu.

La seconda considerazione va fatta per il canale rosso che sorprendentemente diventa più trasparente (attenua di meno) del canale verde nella banda degli UV, cioè dai 300 ai 400 nanometri, ed inoltre si incrocia come sensibilità con il canale blu, diventando più sensibile proprio alle lunghezze d'onda più corte.

Ultima considerazione riguarda la banda degli infrarossi, che possiamo dividere in tre zone: 700-800, 800-900 e 900-1.000 nanometri. Nella prima (che chiameremo da ora in poi IR1) la sensibilità del canale rosso è costante e continua ad essere significativa, mentre blu e verde presentano una sensibilità bassa, anche se crescente; nella seconda zona (IR2) le tre curve si riuniscono presentano sensibilità pressoché uguale. Anche nella terza (IR3) le tre sensibilità corrono affiancate con piccole differenze, ma ormai vanno riducendosi, seguendo la naturale diminuzione di sensibilità del silicio.

È chiaro quindi come la presenza della matrice di Bayer abbia una influenza non trascurabile sulla sensibilità spettrale di una fotocamera modificata Full Range. Ma contrariamente a quanto verrebbe di pensare, questo fatto si rivelerà un enorme vantaggio nello sfruttamento della fotocamera come sensore per applicazioni multispettrali, come vedremo più avanti.